In poco più di vent’anni i datacenter sono passati da essere delle stanze in cui si mettevano, spesso su scaffali, computer che erogavano servizi di rete a veri e propri ecosistemi disegnati per fornire grandi quantità di energia ottimizzandone l’uso e il consumo. I server, gli storage e gli apparati di rete hanno infatti bisogno di dissipare quantità di calore sempre più ingenti che richiedono soluzioni tecniche di raffreddamento sempre più sofisticate al fine di assicurare la migliore condizione possibile per il funzionamento degli apparati e allo stesso tempo il minor costo possibile in termini energetici per raffreddare i sistemi.

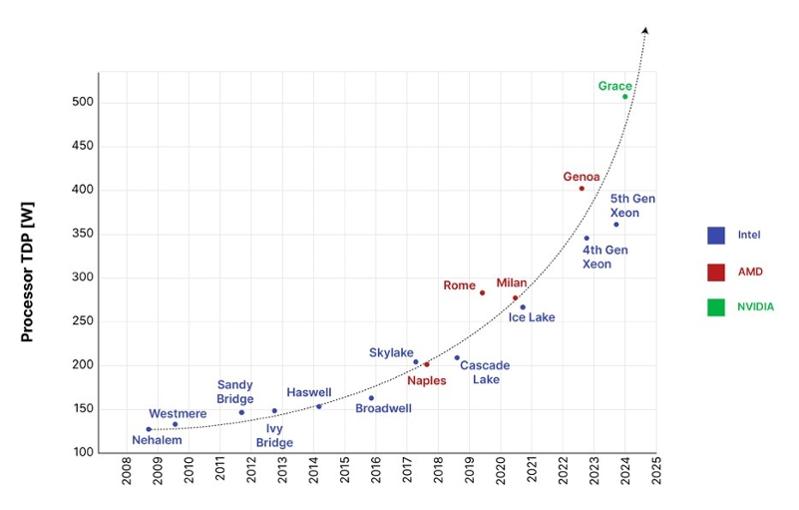

Al fine di garantire le prestazioni necessarie per l’esecuzione di software sempre più esigenti in termini di risorse i produttori di CPU hanno miniaturizzato un numero crescente di transistor portando inevitabilmente ad un aumento del calore da dissipare per ciascun processore (in un grande datacenter si trovano facilmente migliaia di CPU). Il Thermal Design Power (TDP) di una CPU indica la potenza termica da dissipare per il funzionamento e, come si può facilmente vedere, la sua crescita negli ultimi quindici anni è stata più lineare, richiedendo un fattore 5x in più di capacità refrigerante al datacenter per poter assicurare la corretta operatività di questi sistemi. Va anche detto che nei datacenter non vi sono solo processori: per effettuare calcoli ad alte prestazioni sono infatti necessarie anche le cosiddette GPU, processori specializzati per il calcolo vettoriale come quelli prodotti da nVidia e recentemente resi famosi al grande pubblico dall’intelligenza artificiale. Da un punto di vista della dissipazione termica, poi, la necessità di concentrare sempre più transistor in poco spazio si è acuita significativamente negli ultimi 10 anni.

Basti pensare che gli apparati in datacenter sono installati in armadi chiamati rack e solo dieci anni fa un buon design prevedeva 15KW per rack mentre oggi 30KW sono considerati appena sufficienti per un design moderno.

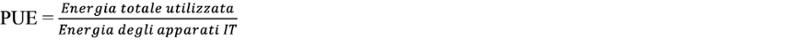

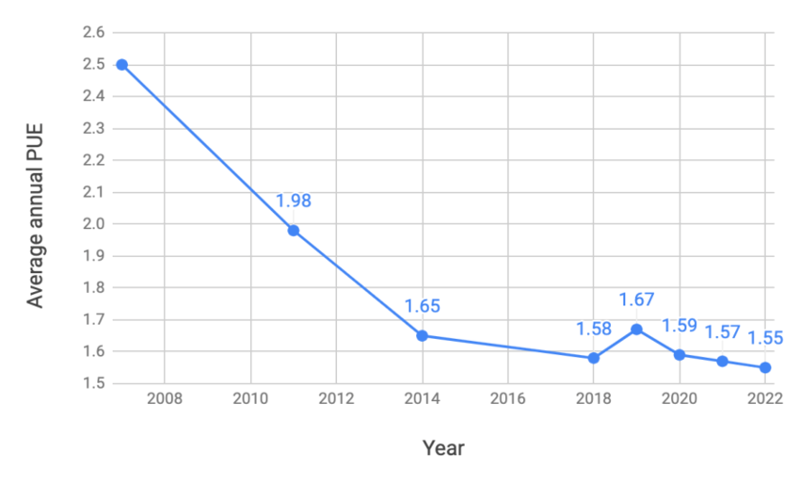

Ma come si sono evoluti i sistemi di raffreddamento per far fronte a questa continua richiesta di capacità refrigerante? Prima di addentrarci nei tre principali design di raffreddamento di datacenter è necessario introdurre la misura più diffusa per valutare grossolanamente l’efficienza di un datacenter, il Power Usage Effectiveness o PUE. Si tratta di un semplice rapporto:

Questo rapporto cattura l’intuizione che nel mondo ideale tutta l’energia dovrebbe essere utilizzata per alimentare gli apparati di rete calcolo e storage, ma poiché raffreddare può richiedere l’uso di energia questo rapporto è inevitabilmente maggiore di uno. All’aumentare dell’energia necessaria per i datacenter si è quindi prestata sempre più attenzione a questo aspetto anche per assicurare il controllo dei costi di esercizio. Ad oggi i datacenter più efficienti hanno un PUE (misurato su base annuale) inferiore a 1,2-1,15.

L’architettura dominante dei datacenter è stata per decenni basata sul raffreddamento dell’aria che viene aspirata dagli apparati con ventole che assicurano il passaggio della stessa attraverso scambiatori di calore che dissipano il calore in eccesso dagli apparati. L’aria calda viene quindi poi recuperata per essere nuovamente raffreddata da sistemi di condizionamento, sia basati su compressione che, più recentemente, su evaporazione.

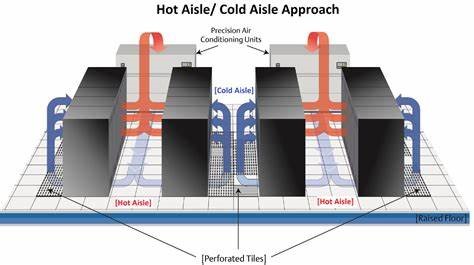

La prima architettura, impiegata a partire dalla seconda metà degli anni novanta, è nota come CRAC, e prevede l’immissione di aria fredda al di sotto del pavimento, con opportune grate che assicurano l’uscita di fronte agli armadi che la usano per raffreddare, mentre l’aria calda viene poi raffreddata da impianti di condizionamento all’interno della sala stessa.

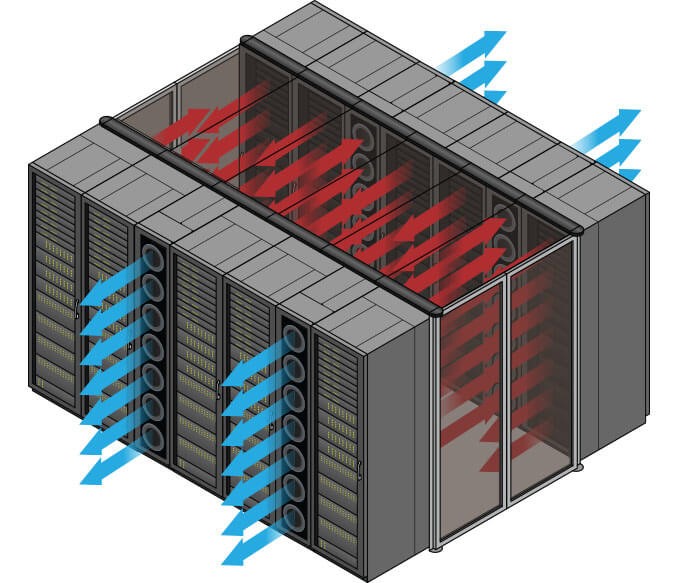

Per far fronte alla sempre maggior richiesta di potenza per rack si è introdotta una differente architettura negli ultimi quindici anni, basata su in-row coolers: gli apparati refrigeranti, ora esterni al datacenter, raffreddano in un circuito chiuso l’acqua che viene inviata a colonne di ventilazione (in-row coolers) che, utilizzando file di ventilatori, forzano il passaggio attraverso un radiatore emettendo aria fredda che poi gli apparati utilizzeranno per raffreddare. L’aria calda, spesso confinata in un corridoio, viene quindi resa disponibile per il nuovo raffreddamento in ingresso come mostrato in figura.

Questo design di datacenter consente di usare apparati refrigeranti molto più efficaci di quelli che si possono impiegare nell’architettura CRAC, in particolare capaci di sfruttare fenomeni di scambio termico naturale senza dover sempre ricorrere all’uso di un compressore e di un refrigerante. Quando questi sistemi non usano il compressore si parla di “free cooling”, ovvero fenomeni di scambio termico naturale sufficienti per assicurare la temperatura prevista dell’aria nel circuito di ingresso nel datacenter.

L’aumento del TDP e di conseguenza della densità termica per unità di volume nei server più recenti pone però un problema più difficoltoso da affrontare: l’aria non è notoriamente un buon conduttore termico, e all’aumentare della quantità di calore da dissipare nell’unità di tempo è semplicemente inadeguata ad assicurare l’adeguata capacità refrigerante se non dovendo alzare significativamente il PUE del datacenter per produrre aria molto fredda.

Negli ultimi anni si sono quindi affermati design in cui un liquido viene fatto entrare direttamente negli apparati IT mediante un circuito che viene posto a contatto con i componenti, per accelerare lo scambio termico, come mostrato in figura, dove un evidente circuito di rame è posto a contatto con i componenti del server da raffreddare.

Vi sono due approcci alla gestione del raffreddamento a liquido: si impiega acqua (con certe caratteristiche specifiche) oppure un liquido specifico come, ad esempio il glicole. L’acqua è facile da reperire, ma in caso di perdita nel circuito di raffreddamento, anche a causa delle alte potenze in gioco, può comportare corto circuiti con rischio di incendio. Altri liquidi come il glicole non conducono la corrente ma la necessità di loro grosse quantità può comportare costi di gestione molto più elevati.

I sistemi di raffreddamento a liquido sono molto più efficienti di quelli basati su aria raffreddata, e i processori e le GPU di fascia alta richiedono ormai il raffreddamento a liquido, elemento pertanto necessario nella realizzazione di sistemi moderni.

Un supercalcolatore come HPC6 di Eni usa il raffreddamento a liquido con un mix di acqua e glicole. In particolare, il raffreddamento a liquido di HPC6 è relativo al 96% della componentistica mentre quello ad aria è necessario per il restante 4%. Ciò consente di raggiungere un valore di PUE molto basso.

Il raffreddamento a liquido sta divenendo un elemento necessario nella realizzazione di nuovi datacenter, sia nella sua forma pura che ibrida.