La prima cosa che ho pensato quando mi è stato chiesto di scrivere un commento sui consumi di energia elettrica dei data center è: perché non chiedere direttamente Chat GPT? A parte facili ironie, il problema è sotto osservazione da tempo. Più o meno un anno fa, l’Agenzia Internazionale di Parigi (IEA) dedicò un approfondimento alla questione, stimando che i data center assorbissero una fetta pari all’1-1,5% del consumo mondiale di elettricità, grossomodo uguale a quella delle reti di trasmissione dati. Due cose vanno chiarite subito su queste stime e sulle previsioni per il futuro. Primo: a differenza delle reti di trasmissioni dati, i data center hanno regioni preferite dove insediarsi e lì il loro peso sui consumi elettrici complessivi può diventare molto alto. Secondo: il possibile impatto sui sistemi elettrici di una futura crescita esponenziale dei consumi dei data center andrebbe valutato in una prospettiva più ampia, dove rientrano, ad esempio, l’elettrificazione dei trasporti privati su gomma e quella degli edifici. Per avere un termine di comparazione, nel 2023 IEA attribuiva alle auto elettriche circolanti nel mondo prelievi per circa 100 TWh, pari ad appena lo 0,4% dei consumi elettrici mondiali e quindi meno della metà dei data center. Ma siamo solo all’inizio, con appena il 3% del parco auto elettrificato.

Secondo EPRI a marzo 2024 il numero di data center in funzione nel mondo era di 10.655, metà dei quali negli Stati Uniti, la regione dove negli ultimi 3 anni la loro crescita è stata più veloce. EPRI distingue tre tipologie: quelli di proprietà di una singola impresa, quelli dove lo spazio è affittato a terzi (co-location) e infine gli hyperscale, data center che possono rapidamente espandere la loro potenza di calcolo per soddisfare le esigenza computazionali di colossi come Google, Microsoft e Amazon.

Il punto di svolta per le previsioni dei consumi elettrici dei data center arriva con la diffusione fulminea di Chat GPT dopo il suo lancio nel novembre del 2022. Più o meno in contemporanea è scattata una corsa forsennata al perfezionamento di modelli e algoritmi più potenti e performanti, alla quale stanno partecipando colossi del calibro di Google, Microsoft, Facebook e IBM. Secondo quanto riportato nel sito DemandSage gli accessi mensili a Chat GPT, dopo avere ampiamente superato il miliardo, sarebbero in netto calo dallo scorso maggio. Può essere soltanto un fatto stagionale. Oppure può segnalare il rapido passaggio di utilizzatori da Chat GPT ai concorrenti. Infine, potrebbe essere un sintomo precoce del fatto che questi modelli non sono sempre all’altezza delle aspettative che hanno creato.

Negli ultimi mesi sono uscite parecchie notizie che hanno spinto al rialzo le previsioni. Un primo esempio è l’ammissione di Microsoft di dovere rivedere i propri obiettivi di neutralità carbonica a causa di maggiori emissioni legate allo sviluppo dell’intelligenza artificiale. Un secondo esempio sono i dati forniti dall’istituto di statistica irlandese, secondo i quali i prelievi di energia elettrica dei data center crescono molto velocemente: dal 2015 al 2023 la loro incidenza sui consumi elettrici nazionali è passata dal 5% al 21%. Per un insieme di ragioni l’Irlanda, come la Virginia del Nord negli Stati Uniti, sta attraendo il loro insediamento e forse per questo, eccezione vistosa nel panorama mondiale, dispone di dati ufficiali sui loro consumi. Anche in questo caso, basta però ampliare la prospettiva per vedere che l’incidenza dei consumi dei data center nell’Unione Europea e negli Stati Uniti è ancora oggetto di stime approssimative, che si collocano su valori largamente inferiori a quelli dell’Irlanda e della Virginia del Nord. Una pubblicazione recentissima del Joint Research Centre indica una forchetta compresa tra 45–65 TWh per il 2022, pari all’1,8–2,6% del consumo totale di energia elettrica nell’EU-27 (JRC 2024). Per gli Stati Uniti, la media delle stime disponibili raccolte da EPRI arriva al 4% dei consumi totali del 2023 (EPRI 2024). Da parte sua, l’Energy Information Administration ha finora azzardato un tentativo di stima solo per i consumi delle criptovalute ma non per le applicazioni dell’intelligenza artificiale.

Torniamo a Microsoft. Secondo quel che scriveva il Wall Street Journal del 15 maggio 2024, in quel caso l’aumento delle emissioni deriverebbe principalmente dalle attività di realizzazione delle infrastrutture (edifici e hardware) per ospitare e gestire its generative AI operations. Emissioni che dunque rientrano nel perimetro Scope 3. Per farsi un’idea più precisa dell’impatto che sta avendo l’intelligenza artificiale sugli obiettivi net zero dei colossi Big Tech suggerisco di consultare l’ultimo environmental report di Google. Nel 2023, i data center di Google hanno assorbito oltre 24 TWh, + 17% rispetto al 2022, equivalenti a poco meno del 10% del totale stimato da IEA. Sebbene Google dichiari di avere compensato il 100% dei prelievi con energia elettrica prodotta da fonte rinnovabile, poiché il profilo orario e geografico degli acquisti non corrisponde perfettamente a quello dei prelievi, in molte circostanze i suoi data center sono stati alimentati dal mix di fonti immesso nelle reti elettriche da cui prelevano. Il risultato finale dei conteggi è che le emissioni Scope 2 —which originate primarily from our data center electricity consumption— sono aumentate del 37% rispetto all’anno prima.

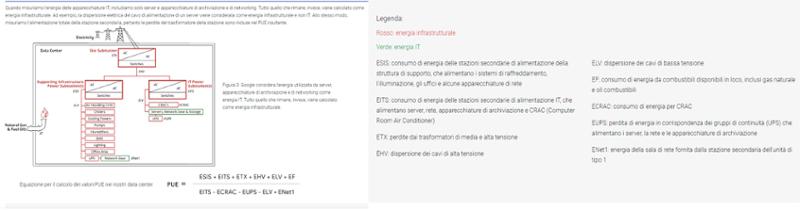

Ma da cosa dipendono i consumi elettrici nei data center? Una quota di energia è dedicata a mantenere gli ambienti in un range di temperatura che non comprometta il funzionamento dell’hardware. Un’altra parte è assorbita dall’elaborazione e dalla gestione dei dati. Una metrica energetica molto diffusa, e potenzialmente ingannevole, nel mondo dei data center è il Power Usage Effectiveness (PUE), che è espressa dal rapporto tra consumo totale di energia elettrica del data center e la quota di energia elettrica dedicata all’elaborazione e alla gestione dei dati (vedi figure).

Schema per il calcolo del PUE

Fonte: https://www.google.com/about/datacenters/efficiency/

Negli anni passati i miglioramenti di efficienza hanno riguardato soprattutto il consumo di energia per il condizionamento degli ambienti, ottenendo risultati ragguardevoli: the industry average PUE dropped from 2.5 in 2007 to 1.98 in 2011, reaching 1.65 by 2014. Nell’environmental report, Google dichiara un valore di PUE pari a 1,10 nel 2023 rispetto a una media del settore di 1,58. Basta però guardare con attenzione la formula del PUE per capire che l’indicatore può migliorare, senza necessariamente migliorare l’efficienza con cui l’energia è utilizzata per elaborare e gestire i dati.

I modelli di intelligenza artificiale che si stanno diffondendo sono tipicamente più energy intensive di tutte le precedenti applicazioni di elaborazione e gestione dati effettuate in un data center. Anche in questo caso mancano dati certi sulla quota dei consumi elettrici attuali attribuibile all’intelligenza artificiale. La stima più recente è sempre nella pubblicazione EPRI già citata: AI applications are estimated to use only 10%–20% of data center electricity today.

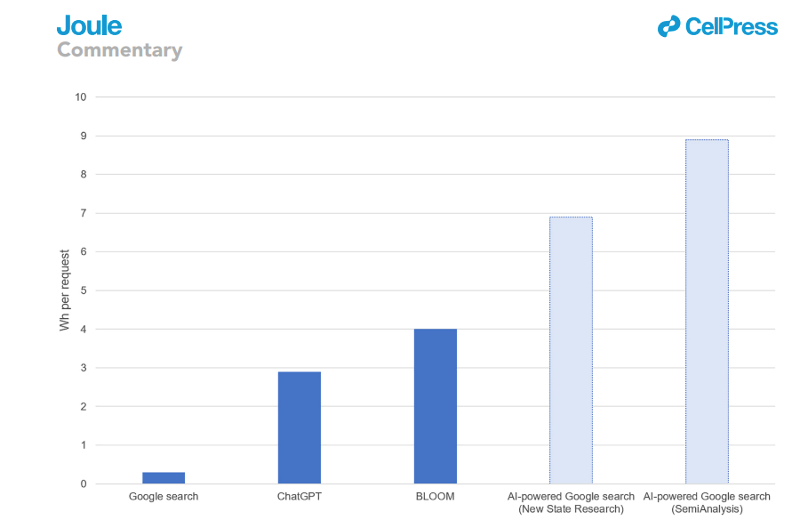

L’intelligenza artificiale assorbe molta energia nella fase di addestramento e test dei modelli (training phase). Quando i modelli diventano accessibili agli utilizzatori il loro consumo diventa proporzionale all’uso (inference phase). Anche questa fase sembrerebbe molto più energy intensive rispetto alle applicazioni che l’intelligenza artificiale potrebbe sostituire, anche se l’output ottenuto dall’utilizzatore dovrebbe essere molto più accurato. Un esempio utile per avere un’idea degli ordini di grandezza in ballo, e che è stato ripreso molte volte, è il seguente. Per soddisfare la richiesta di un utilizzatore a Chat GPT servono in media 2.9 watt-ora, un consumo dieci volte superiore a quello necessario alle traditional Google queries, which use about 0.3 watt-hours each (vedi figura).

Consumo energetico stimato per vari sistemi alimentati da Al rispetto a un sistema di ricerca standard di Google

Fonte: de Vries, The growing energy footprint of artificial intelligence, Joule (2023)

L’attenzione si sta a questo punto concentrando sull’efficienza energetica nell’addestramento e nell’uso dell’intelligenza artificiale. In apparenza, essa sta migliorando molto velocemente e non si sa fino a che punto l’innovazione riuscirà a spingersi in questi specifici campi. Nvidia stima che la nuova generazione di GPU (graphics processing units) destinata ai clienti Cloud dei data center utilizzerà il 75% in meno di energia rispetto alle precedenti generazioni per completare gli stessi compiti nella training phase dei modelli. Questo miglioramento sarebbe però accompagnato da un incremento del 300% della potenza della GPU, che avrà certamente effetti sui consumi per la climatizzazione dei data center. Anche senza avere accesso diretto ai laboratori di ricerca, il sospetto che l’obiettivo principale di chi sviluppa le GPU non sia tanto ridurre i consumi energetici dei data center, quanto supportare l’addestramento di trillion-plus large language models è forte.

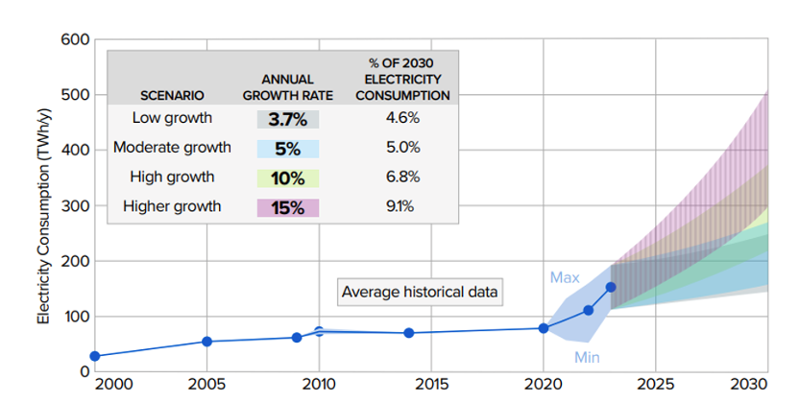

Ci sono almeno tre ragioni e un potenziale vincolo per rendere le previsioni sui futuri consumi di energia elettrica dei data center uscite in questi mesi molto poco affidabili. Le tre ragioni che lavorano insieme a produrre un ambiente ad altissimo tasso di incertezza sono: l’intensità competitiva, la dinamica innovativa e la risposta della domanda. Quanti saranno i soggetti che vorranno testare nuovi modelli e quale sarà la frequenza di lancio di nuovi modelli? Quale capacità di calcolo sarà necessaria per addestrarli? Come si diffonderà l’intelligenza artificiale tra gli utilizzatori? Credo che nessuno sappia dare risposte a queste domande nell’orizzonte temporale coperto da queste previsioni, come del resto scrive anche Google nel suo environmental report: Predicting the future environmental impact of AI is complex and evolving, and our historical trends likely don’t fully capture AI’s future trajectory. EPRI, da parte sua, ricorre al classico approccio prudenziale degli scenari di crescita per verificare il differente impatto sui sistemi elettrici anche dei singoli Stati (vedi figura).

Stima del potenziale consumo di elettricità del data center statunitensi nel periodo 2023-2030

N.B : la percentuale della proiezione del consumo di elettricità al 2030 presuppone che tutti gli altri carichi (non data center) aumentino dell'1% annuo

Fonte: EPRI 2024

Il vincolo che potrà rallentare una tendenza a una crescita dei consumi elettrici molto accelerata è legato agli impatti dei nuovi data center sulle reti elettriche locali e sui sistemi elettrici. Secondo EPRI, la tipologia hyperscale ha ormai taglie di potenza superiori a 100 MW, che possono spingersi in determinate configurazioni fino a 1 GW. Se chi realizza queste opere si aspetta tempi di connessione veloci e forniture elettriche affidabili e decarbonizzate, allora i siti in grado di soddisfare tutte queste condizioni diventeranno inevitabilmente scarsi.

Questo quadro previsivo non considera i miglioramenti che le applicazioni dell’intelligenza artificiale potranno certamente portare nel campo della gestione delle produzioni intermittenti di energia elettrica, della flessibilità delle immissioni e dei prelievi, e dell’efficienza energetica. Una diffusione molto estesa dell’intelligenza artificiale in questi campi è ovviamente auspicabile, ma i suoi effetti positivi diventeranno apprezzabili in tempi più lunghi di quelli considerati dalle previsioni sui consumi di energia elettrica dei data center qui commentate. Da profano, mi sento comunque di prevedere che queste applicazioni “energetiche” impegneranno una porzione molto ridotta dell’infrastruttura di calcolo dei data center.